Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Physical Address

304 North Cardinal St.

Dorchester Center, MA 02124

Mechanika kwantowa stanowi jeden z największych przełomów w historii nauki, fundamentalnie zmieniając nasze rozumienie natury rzeczywistości na poziomie atomowym i subatomowym. Ta teoria fizyczna, rozwijana od początku XX wieku, nie tylko obaliła klasyczne wyobrażenia o deterministycznym charakterze świata, ale również stworzyła fundament dla współczesnych technologii, które otaczają nas na co dzień. Od laserów i tranzystorów po komputery kwantowe i kryptografię – mechanika kwantowa przekształciła zarówno naukę, jak i cywilizację.

Na początku XX wieku fizyka wydawała się być nauką praktycznie ukończoną. Mechanika Newtona doskonale opisywała ruch planet i obiektów makroskopowych, elektrodynamika Maxwella wyjaśniała zjawiska elektromagnetyczne, a termodynamika pozwalała rozumieć procesy energetyczne. Jednak kilka niezrozumiałych zjawisk zaczęło podważać tę pozorną kompletność fizyki klasycznej.

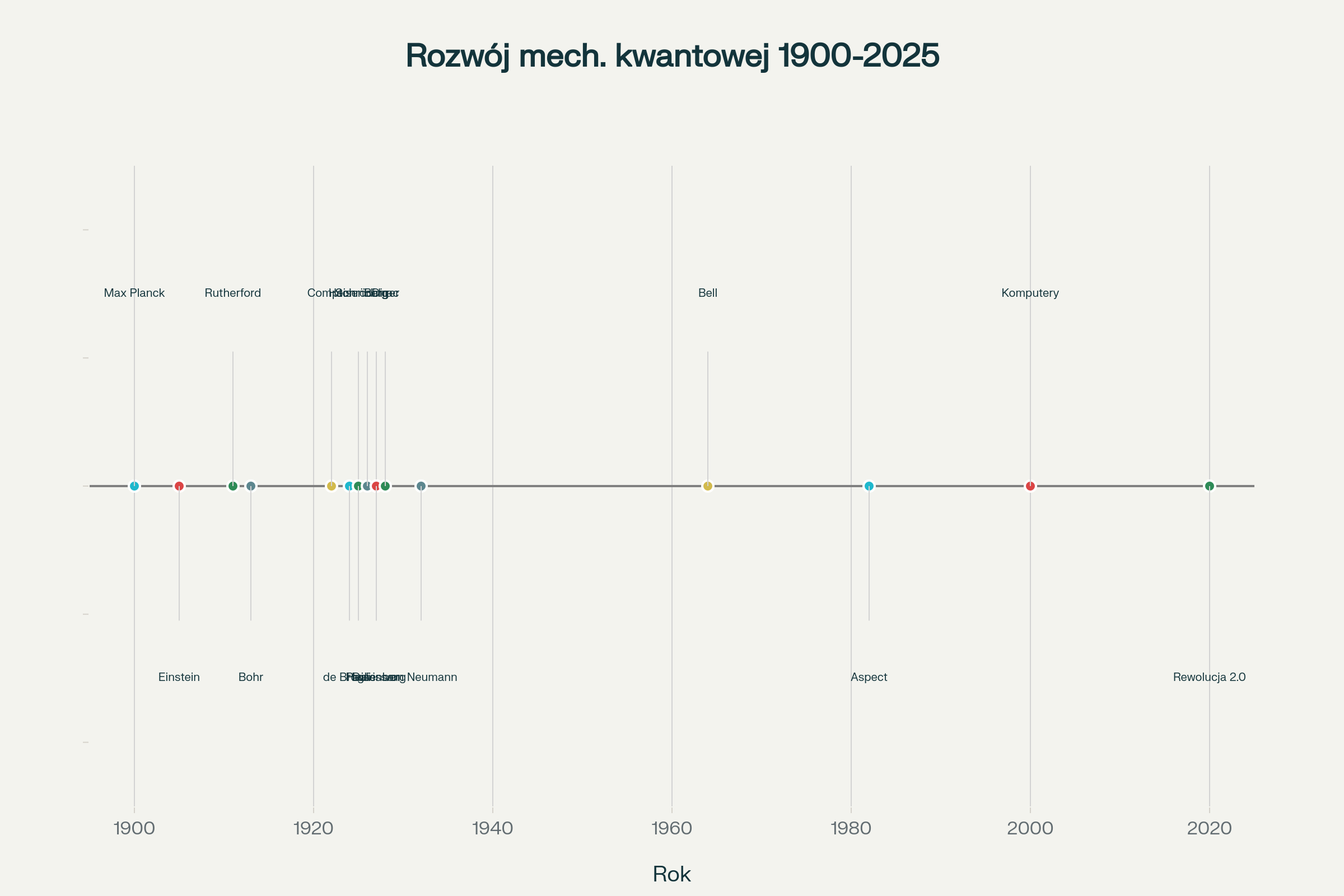

Pierwszym przełomowym momentem był rok 1900, kiedy Max Planck próbował rozwiązać problem promieniowania ciała doskonale czarnego. Klasyczna fizyka przewidywała, że ciało doskonale czarne powinno emitować nieskończoną ilość energii w zakresie ultrafioletowym – tzw. katastrofę ultrafioletową. Planck, aby dopasować teorię do obserwacji, wprowadził rewolucyjną koncepcję kwantów energii, zakładając że energia może być emitowana jedynie w dyskretnych porcjach proporcjonalnych do częstotliwości.

Pięć lat później Albert Einstein poszedł jeszcze dalej, wyjaśniając zjawisko fotoelektryczne poprzez przyjęcie, że samo światło składa się z dyskretnych cząstek – fotonów. Ten odważny krok oznaczał powrót do korpuskularnej teorii światła, która była wcześniej odrzucona na rzecz falowej teorii Maxwella. Einstein wykazał, że energia fotonu jest proporcjonalna do jego częstotliwości zgodnie ze wzorem E = hν, gdzie h to stała Plancka, wprowadzona wcześniej przez niemieckiego fizyka.

Zjawisko Comptona z 1922 roku ostatecznie potwierdziło korpuskularną naturę fotonów, pokazując jak fotony mogą zderzać się z elektronami jak klasyczne cząstki. Te odkrycia doprowadziły do fundamentalnego problemu: światło zachowuje się jednocześnie jak fala i jak cząstka, w zależności od rodzaju eksperymentu.

Louis de Broglie w 1924 roku zaproponował rewolucyjną hipotezę, że nie tylko światło, ale również materia wykazuje dualną naturę falowo-korpuskularną. Zgodnie z jego teorią, każdej cząstce o pędzie p można przypisać długość fali λ = h/p. Ta koncepcja była tak radykalna, że nawet sam de Broglie miał wątpliwości co do jej słuszności.

Eksperymentalne potwierdzenie przyszło w 1927 roku, kiedy Davisson i Germer zaobserwowali dyfrakcję elektronów na kryształach. Elektrony, uważane dotychczas za typowe cząstki, wykazywały falowe właściwości, tworząc charakterystyczne obrazy interferencyjne. To odkrycie ostatecznie przekonało społeczność naukową o słuszności hipotezy de Broglie’a i konieczności stworzenia całkowicie nowej teorii opisującej mikroświat.

Werner Heisenberg w lipcu 1925 roku zaproponował pierwszą kompletną wersję mechaniki kwantowej, znaną jako mechanika macierzowa. Jego podejście było radykalnie odmienne od klasycznej fizyki – zamiast opisywać trajektorie cząstek, Heisenberg skupił się na wielkościach obserwowalnych i ich wzajemnych relacjach. W jego formaliźmie wielkości fizyczne były reprezentowane przez macierze, a ich pomiar dawał prawdopodobieństwa różnych wyników.

Max Born i Pascual Jordan rozwinęli dalej idee Heisenberga, tworząc matematyczny fundament mechaniki macierzowej. Ich prace pokazały, że kolejność wykonywania operacji w świecie kwantowym ma fundamentalne znaczenie – mnożenie macierzy nie jest przemienne, co prowadzi do głębokich konsekwencji fizycznych.

Równolegle, Erwin Schrödinger w 1926 roku opracował alternatywną formę mechaniki kwantowej, znaną jako mechanika falowa. Jego słynne równanie opisuje ewolucję funkcji falowej układu kwantowego w czasie. Funkcja falowa zawiera całą dostępną informację o układzie i pozwala obliczać prawdopodobieństwa różnych wyników pomiarów.

Schrödinger udowodnił matematyczną równoważność swojego podejścia z mechaniką macierzową Heisenberga, pokazując że są to różne reprezentacje tej samej teorii. Mechanika falowa okazała się bardziej intuicyjna dla fizyków przyzwyczajonych do równań różniczkowych i szybko zyskała popularność.

W 1927 roku Heisenberg sformułował jedną z najbardziej fundamentalnych zasad mechaniki kwantowej – zasadę nieoznaczoności. Stwierdza ona, że nie można jednocześnie dokładnie zmierzyć dwóch komplementarnych wielkości, takich jak położenie i pęd cząstki. Matematycznie wyraża się to nierównością Δx·Δp ≥ ℏ/2, gdzie ℏ to zredukowana stała Plancka.

Zasada nieoznaczoności nie wynika z niedoskonałości przyrządów pomiarowych, ale jest fundamentalną właściwością natury. Pokazuje, że na poziomie kwantowym rzeczywistość jest zasadniczo probabilistyczna, a nie deterministyczna jak w fizyce klasycznej.

Niels Bohr wraz z grupą fizyków z Kopenhagi stworzył w latach 20. XX wieku najbardziej wpływową interpretację mechaniki kwantowej. Interpretacja kopenhaska mówi, że funkcja falowa nie opisuje obiektywnej rzeczywistości fizycznej, lecz reprezentuje naszą wiedzę o układzie kwantowym.

Zgodnie z tym podejściem, pomiar powoduje „kolaps” funkcji falowej – przejście od superpozycji wszystkich możliwych stanów do jednego konkretnego stanu. Interpretacja kopenhaska wprowadza fundamentalną rolę obserwatora i kwestionuje możliwość opisania rzeczywistości niezależnie od procesu pomiaru.

Hugh Everett III w 1957 roku zaproponował radykalnie odmienną interpretację, znaną jako interpretacja wieloświatowa lub interpretacja wielu światów. Według tej teorii, nie dochodzi do kolapsu funkcji falowej – wszystkie możliwe wyniki pomiaru realizują się jednocześnie w różnych „odnogach” rzeczywistości.

W interpretacji Everetta wszechświat nieustannie się rozgałęzia, tworząc nieskończoną liczbę równoległych rzeczywistości. David Deutsch rozwinął tę koncepcję, sugerując że komputery kwantowe mogą wykorzystywać obliczeniową moc równoległych wszechświatów.

Mechanika kwantowa doczekała się wielu innych interpretacji, w tym teorii ukrytych parametrów de Broglie’a-Bohma, interpreacji opartej na dekoherencji kwantowej oraz interpretacji opartej na świadomości. Każda z tych interpretacji oferuje inne spojrzenie na naturę rzeczywistości kwantowej, jednak wszystkie prowadzą do identycznych przewidywań eksperymentalnych.

Superpozycja stanowi jedno z najbardziej charakterystycznych zjawisk mechaniki kwantowej. Oznacza ona, że układy kwantowe mogą istnieć jednocześnie w wielu stanach, dopóki nie zostanie dokonany pomiar. Klasycznym przykładem ilustrującym to zjawisko jest słynny eksperyment myślowy Schrödingera z kotem, który może być jednocześnie żywy i martwy.

Matematycznie superpozycja wyraża się jako kombinacja liniowa stanów bazowych. Jeśli układ może znajdować się w stanie |A⟩ lub |B⟩, to w mechanice kwantowej możliwy jest również stan α|A⟩ + β|B⟩, gdzie α i β to współczynniki zespolone

. Ta właściwość umożliwia komputerom kwantowym przetwarzanie wielu możliwości obliczeniowych jednocześnie.

Splątanie kwantowe to zjawisko, w którym dwie lub więcej cząstek tworzy jeden, niepodzielny system kwantowy. Cząstki splątane pozostają skorelowane niezależnie od odległości między nimi – zmiana stanu jednej cząstki natychmiast wpływa na stan drugiej.

Einstein nazwał splątanie „upiornym działaniem na odległość” i był przekonany, że mechanika kwantowa jest teorią niekompletną. Jednak eksperymenty Johna Clausera, Alaina Aspecta i Antona Zeilingera (laureaci Nagrody Nobla w 2022 roku) ostatecznie potwierdziły realność splątania kwantowego. Te badania wykazały łamanie nierówności Bella, dowodząc nielokalnego charakteru mechaniki kwantowej.

Tunelowanie kwantowe pozwala cząstkom przechodzić przez bariery energetyczne, które w fizyce klasycznej byłyby nieprzekraczalne. To zjawisko wynika z falowej natury materii – funkcja falowa cząstki może „przesączyć się” przez barierę, nawet jeśli cząstka ma zbyt małą energię, aby ją pokonać klasycznie.

Tunelowanie ma fundamentalne znaczenie dla wielu procesów fizycznych i technologicznych. Umożliwia reakcje jądrowe w gwiazdach, działanie diod tunelowych, skaningowej mikroskopii tunelowej oraz wielu innych zastosowań.

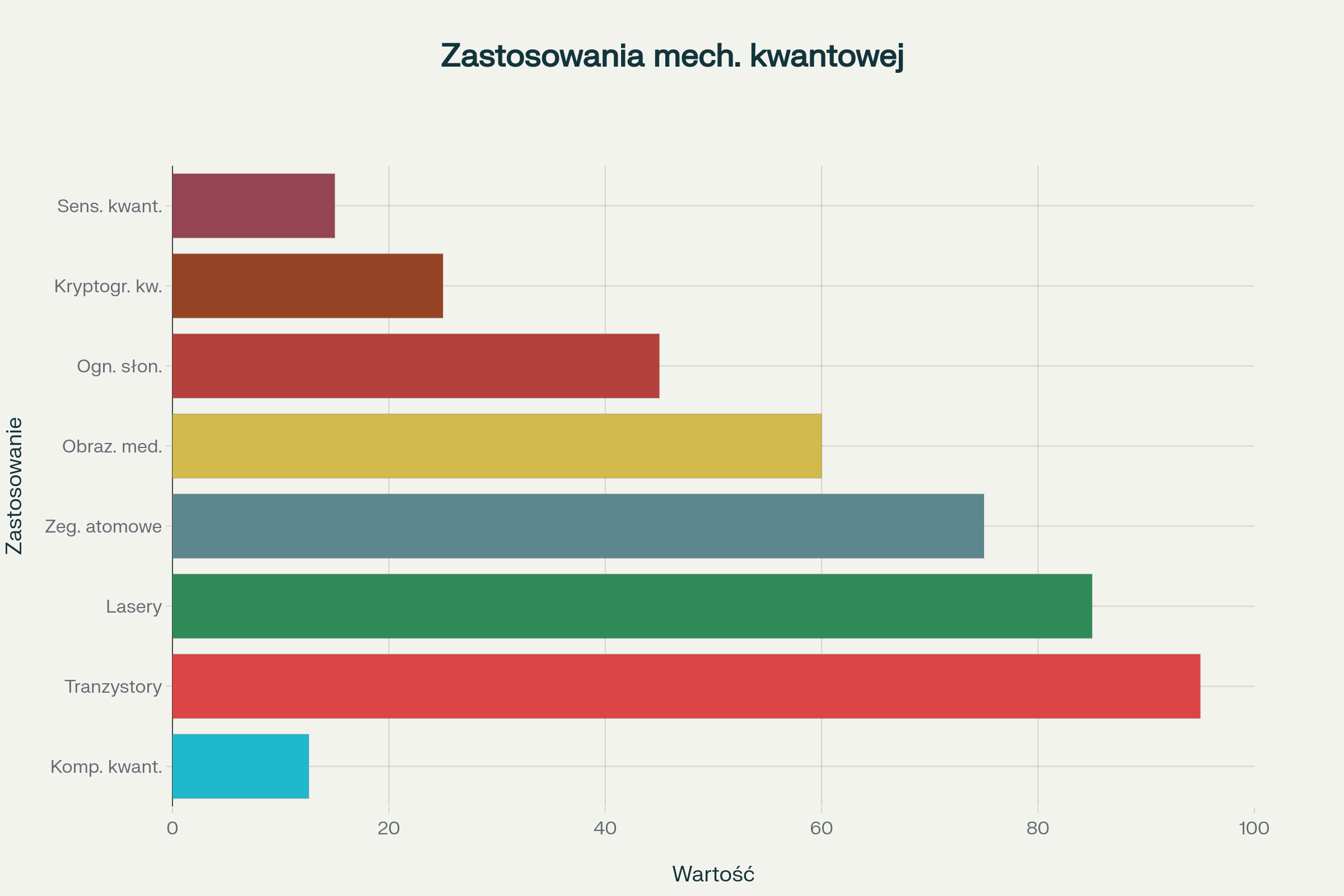

Komputery kwantowe wykorzystują zasady superpozycji i splątania do wykonywania obliczeń niemożliwych dla komputerów klasycznych. Podczas gdy bit klasyczny może przyjmować wartość 0 lub 1, kubit (bit kwantowy) może istnieć w superpozycji obu stanów jednocześnie.

Największe korporacje technologiczne, w tym IBM, Google i Microsoft, intensywnie rozwijają technologie kwantowe. Google ogłosił w 2024 roku osiągnięcie „supremacji kwantowej” ze swoim chipem Willow, który wykonał obliczenia w czasie krótszym niż 5 minut, podczas gdy najszybszemu superkomputerowi zajęłoby to 10 septylionów lat.

Komputery kwantowe mają potencjał do rewolucjonizacji wielu dziedzin: optymalizacji logistycznej, projektowania nowych materiałów i leków, modelowania klimatycznego oraz kryptografii. Przewiduje się, że wartość rynku komputerów kwantowych osiągnie 16,4 miliarda dolarów do 2027 roku.

Kryptografia kwantowa oferuje teoretycznie niemożliwe do złamania metody zabezpieczania informacji. Quantum Key Distribution (QKD) wykorzystuje właściwości pojedynczych fotonów do bezpiecznej wymiany kluczy kryptograficznych.

Protokoły takie jak BB84 czy protokół Ekerta wykorzystują zasadę nieoznaczoności i splątanie kwantowe do wykrywania prób podsłuchu. Każda próba przechwycenia informacji nieuchronnie zaburza stan kwantowy, ostrzegając legitymiczne strony o naruszeniu bezpieczeństwa.

Lasery, oparte na indukowanej emisji promieniowania, stanowią jedno z najbardziej powszechnych zastosowań mechaniki kwantowej. Działanie laserów polega na wykorzystaniu inwersji populacji w układach kwantowych do generowania spójnego promieniowania elektromagnetycznego.

Współczesne lasery znajdują zastosowanie w medycynie (operacje oka, terapie onkologiczne), przemyśle (cięcie i spawanie materiałów), telekomunikacji (światłowody), rozrywce oraz badaniach naukowych. Rozwój laserów umożliwił również powstanie technologii CD, DVD, drukarek laserowych i czytników kodów kreskowych.

Tranzystory, podstawa całej współczesnej elektroniki, działają dzięki zjawiskom kwantowym w półprzewodnikach. Mechanika kwantowa wyjaśnia powstawanie pasm energetycznych w kryształach oraz zachowanie elektronów i dziur w złączach p-n.

Bez zrozumienia mechaniki kwantowej nie byłoby możliwe stworzenie komputerów, smartfonów, telewizorów ani jakichkolwiek urządzeń elektronicznych. Dalszy rozwój elektroniki, w tym komputery molekularne i urządzenia spintroniczne, również opiera się na wykorzystaniu efektów kwantowych.

Rezonans magnetyczny (MRI) wykorzystuje kwantowe właściwości spinów jądrowych do tworzenia obrazów wnętrza ciała ludzkiego. Pozytonowa tomografia emisyjna (PET) opiera się na anihilacji pozyton-elektron, umożliwiając obrazowanie procesów metabolicznych.

Te technologie rewolucjonizowały diagnostykę medyczną, pozwalając na nieinwazyjne badanie tkanek miękkich, mózgu, układu krążenia i wykrywanie nowotworów we wczesnych stadiach rozwoju.

Mechanika kwantowa radykalnie zmienia nasze rozumienie procesu obserwacji. W fizyce klasycznej pomiar jedynie ujawnia już istniejące właściwości obiektu, podczas gdy w mechanice kwantowej sam akt pomiaru może wpływać na wynik.

Problem pomiaru pozostaje jednym z najbardziej kontrowersyjnych aspektów mechaniki kwantowej. Kiedy dokładnie następuje kolaps funkcji falowej? Jaka jest rola świadomego obserwatora? Te pytania dotykają fundamentalnych kwestii dotyczących natury rzeczywistości i naszego miejsca we wszechświecie.

Einstein słynnie stwierdził, że „Bóg nie gra w kości”, wyrażając swój sprzeciw wobec probabilistycznej interpretacji mechaniki kwantowej. Jednak eksperymenty konsekwentnie potwierdzają, że na poziomie kwantowym rzeczywistość jest fundamentalnie probabilistyczna.

Ta probabilistyczna natura mechaniki kwantowej ma głębokie implikacje dla pojęcia wolnej woli. Niektórzy filozofowie argumentują, że kwantowy indeterminizm może stanowić podstawę dla wolnej woli, podczas gdy inni uważają, że przypadkowość nie jest równoznaczna z wolnością.

Nierówności Bella i eksperymenty je testujące pokazują, że przynajmniej jedna z dwóch fundamentalnych założeń musi być fałszywa: albo rzeczywistość nie jest lokalna (wpływy mogą działać natychmiast na dowolną odległość), albo nie jest realistyczna (właściwości nie istnieją niezależnie od obserwacji).

Większość fizyków akceptuje nielokalnośc mechaniki kwantowej, co oznacza, że informacja może być przekazywana między splątanymi cząstkami szybciej niż światło. To nie narusza teorii względności, ponieważ nie można używać splątania do przesyłania użytecznej informacji.

Współczesna nauka wchodzi w erę „drugiej rewolucji kwantowej”. Podczas gdy pierwsza rewolucja doprowadziła do stworzenia tranzystorów i laserów, druga koncentruje się na kontroli pojedynczych cząstek kwantowych i wykorzystaniu zjawisk takich jak superpozycja i splątanie do praktycznych zastosowań.

Najważniejsze kierunki rozwoju obejmują komputery kwantowe, sensory kwantowe o bezprecedensowej precyzji, sieci komunikacji kwantowej oraz symulatory kwantowe do badania złożonych układów fizycznych. Unia Europejska zainwestowała ponad 100 milionów euro w rozwój europejskiej infrastruktury kwantowej.

Połączenie mechaniki kwantowej ze sztuczną inteligencją otwiera nowe możliwości w analizie danych i uczeniu maszynowym. Quantum Machine Learning (QML) wykorzystuje właściwości komputerów kwantowych do przyspieszenia algorytmów sztucznej inteligencji.

Algorytmy kwantowe mogą potencjalnie rozwiązywać problemy optymalizacyjne, klasyfikacji i rozpoznawania wzorców znacznie szybciej niż klasyczne komputery. To może prowadzić do przełomów w medycynie spersonalizowanej, prognozowaniu pogody, analizie rynków finansowych oraz projektowaniu nowych materiałów.

Sensory kwantowe wykorzystują delikatną naturę stanów kwantowych do precyzyjnych pomiarów. Magnetometry kwantowe mogą wykrywać pola magnetyczne z dokładnością przekraczającą tradycyjne instrumenty o kilka rzędów wielkości.

Zastosowania obejmują poszukiwanie złóż mineralnych, monitorowanie aktywności mózgu, wykrywanie obiektów pod wodą oraz badania fundamentalnych stałych fizycznych. Atomowe zegary kwantowe umożliwiają precyzyjne testy teorii względności i mogą doprowadzić do rewizji naszego rozumienia czasu i przestrzeni.

Pomimo obiecujących perspektyw, technologie kwantowe stoją przed poważnymi wyzwaniami. Dekoherencja kwantowa – utrata koherencji kwantowej wskutek oddziaływania z otoczeniem – pozostaje głównym problemem limitującym działanie urządzeń kwantowych.

Korekcja błędów kwantowych wymaga tysięcy fizycznych kubitów do stworzenia jednego logicznego kubitu odpornego na błędy. Temperatura pracy większości systemów kwantowych musi być utrzymywana blisko zera absolutnego, co stwarza znaczące wyzwania inżynierskie.

Technologie kwantowe mają potencjał do fundamentalnej transformacji wielu sektorów gospodarki. W przemyśle farmaceutycznym komputery kwantowe mogą przyspieszać projektowanie nowych leków poprzez symulowanie oddziaływań molekularnych.

Sektor finansowy może wykorzystywać kwantowe algorytmy optymalizacyjne do zarządzania ryzykiem portfela i wysokoczęstotliwościowego handlu. Logistyka i transport mogą skorzystać z kwantowych algorytmów do optymalizacji tras i zarządzania łańcuchami dostaw.

Rozwój technologii kwantowych staje się areną międzynarodowej konkurencji technologicznej. Stany Zjednoczone, Chiny i Unia Europejska inwestują miliardy dolarów w badania kwantowe, traktując je jako strategiczne dla bezpieczeństwa narodowego.

Komputery kwantowe mogą w przyszłości łamać obecnie używane systemy kryptograficzne, co wymaga opracowania nowych, odpornych na ataki kwantowe metod szyfrowania. To tworzy wyścig między rozwojem komputerów kwantowych a kryptografią post-kwantową.

Rozwój technologii kwantowych rodzi nowe pytania etyczne. Kto będzie miał dostęp do potęgi komputerów kwantowych? Jak zapewnić, że korzyści z technologii kwantowych będą sprawiedliwie dystrybuowane?

Potencjał komputerów kwantowych do łamania szyfrowania może zagrozić prywatności i bezpieczeństwu danych osobowych. Jednocześnie kryptografia kwantowa może oferować bezprecedensowy poziom bezpieczeństwa dla tych, którzy będą mieli do niej dostęp.

Mechanika kwantowa przeszła długą drogę od spekulatywnych hipotez Plancka i Einsteina do podstawy współczesnej technologii. Ta teoria nie tylko zrewolucjonizowała nasze rozumienie rzeczywistości, ale również umożliwiła powstanie większości technologii, które otaczają nas dzisiaj. Od komputerów i smartfonów po obrazowanie medyczne i systemy nawigacyjne – wszystko to zawdzięczamy mechanice kwantowej.

Stoimy obecnie na progu drugiej rewolucji kwantowej, która może być jeszcze bardziej transformacyjna niż pierwsza. Komputery kwantowe, sensory kwantowe i kryptografia kwantowa mają potencjał do rozwiązania problemów, które wydają się niemożliwe dla obecnych technologii. Jednocześnie mechanika kwantowa stawia przed nami głębokie pytania filozoficzne o naturę rzeczywistości, determinizm, lokalność i rolę obserwatora.

Przyszłość technologii kwantowych będzie zależeć od naszej zdolności do przezwyciężenia technicznych wyzwań związanych z dekoherencją i korekcją błędów. Równie ważne będą decyzje dotyczące etycznego i sprawiedliwego wykorzystania tych potężnych technologii. Mechanika kwantowa uczy nas, że rzeczywistość jest znacznie bardziej dziwna i fascynująca, niż mogliśmy sobie wyobrazić, a jej pełny potencjał dopiero zaczynamy odkrywać.